Jedną z trudności analizy wskaźnikowej (w analizie fundamentalnej) jest to, że nie wiadomo jakiej użyć średniej do porównań. Jeśli w sektorze znajdują się obserwacje odstające, to średnia arytmetyczna (A) będzie zaniżać lub zawyżać porównawczy wskaźnik. Najbardziej znanym sposobem radzenia sobie z tym to zastosowanie mediany (M). Jednak wydaje się, że jest to błędna metoda. Mediana pokazuje jedynie środek przedziału, a nie to co chcielibyśmy uznać za punkt odniesienia. Powiedzmy, że mamy 5 spółek o takich wskaźnikach cena/zysk: 20, 20, 3, 3, 3. Mediana wynosi 3, a więc w ogóle nie uwzględnia występowania spółek o P/E = 20. Teraz odwróćmy sytuację: 20, 20, 20, 3, 3. Mediana nagle skacze do 20 tylko dlatego, że jedna spółka zmieniła wartość. W obu przypadkach lepszym rozwiązaniem byłoby użycie średniej arytmetycznej, która w pierwszym przykładzie daje 9,8, a w drugim 13,2. Gdyby jednak zaczęły występować wartości nietypowe, to znów M byłaby lepsza. Na przykład jeżeli w sektorze jest 11 spółek, a jednej z nich zdarzyło się jednorazowe wydarzenie,

które sprawiło, że zysk na akcję = 0,01, to, ponieważ wiadomo, że nie ma to wpływu na przyszłe wyniki, rynkowa wycena akcji wynosi 100

zł. Wtedy (chwilowe) P/E = 10000. Pozostałych 10 spółek ma P/E na poziomie ok. 3.

Wtedy M = 3, A = 911. Oczywiste, że zwykła średnia kompletnie nie nadaje się do analizy.

Ani mediana, ani średnia arytmetyczna nie są dobrym rozwiązaniem.

Zamiast tych dwóch miar lepszym sposobem jest zastosowanie średniej geometrycznej (G). Dla pierwszego przykładu dałaby ona 6,4, a dla drugiego 9,4. Dla trzeciego przykładu z jedną obserwacją odstającą dostaniemy G = 6,27. Czyli średnia ta rzeczywiście pokonuje zarówno A jak i M.

Występują jednak sytuacje, gdy G staje się także wątpliwa. Przykład, w którym jedna spółka ma P/E 10 000 to rzadka sytuacja, ale już gdyby P/E równało się 100, nie byłoby w tym nic nadzwyczajnego. Weźmy więc taki przykład listy P/E: 100, 5, 5, 5, 4, 4, 4, 3, 3, 3. Tutaj G = 5,4, podczas gdy M = 4. Ponieważ 100 to wartość odstająca, to właściwa średnia powinna jak najmocniej usunąć jej wpływ. I choć geometryczna radzi sobie nie najgorzej, to mediana okazuje się tu lepsza. Jeżeli badamy spółkę o P/E = 5 z tego sektora, to analiza wskaźnikowa oparta o G powie, że spółka mieści się w dozwolonym obszarze, a oparta o M prawidłowo uzna, że spółka wykracza poza dozwolony obszar do inwestycji.

Wśród inwestorów mało znanym narzędziem jest średnia harmoniczna (H). To ona może okazać się rozwiązaniem w takich dylematach. H jest wrażliwsza od M, ale mniej wrażliwa od A i G - ta zaleta daje często przewagę nad pozostałymi. Dla wyżej podanego przykładu H = 4,24, czyli trochę więcej niż M. W podanym przykładzie nie ma to większego znaczenia, ale gdybyśmy dodali do listy jeszcze jedną spółkę o P/E = 100, to prawdopodobnie oczekiwalibyśmy, że sprawiedliwa miara delikatnie uwzględni wystąpienie tych skrajności, które się powtarzają. I wówczas H = 4,6, podczas gdy M nadal 4.

Niestety H nie jest złotym środkiem na wszystkie przypadki. Dla pierwszego przykładu wynosi ona 4,55, a dla drugiego 6,12. Oznacza to, że mniejsze wartości więcej ważą w tej średniej. Może być to atutem dla inwestora szukającego bezpiecznych inwestycji, które posiadają niski P/E. Można się pokusić o tezę, że:

- A służy inwestorowi skłonnemu do ryzyka,

- G inwestorowi obojętnemu wobec ryzyka,

- H inwestorowi z awersją do ryzyka.

Tak więc G jest bardziej obiektywna, a A i H subiektywne. Zwróćmy jednak uwagę, że w każdym z tych przykładów H była bardziej użyteczna od M. Ale nie zawsze tak będzie. H jest subiektywna w tym sensie, że penalizuje wysokie wartości, a niskie nagradza. Przez to jest nie tylko subiektywna, ale także nadwrażliwa w sytuacji, gdy występują wartości odstające na lewo - bliskie zera.

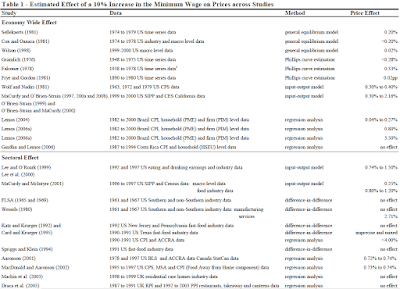

Porównajmy rzeczywiste dane z sektora elektro-przemysłowego:

Źródło: https://www.biznesradar.pl/

Można powiedzieć, że pierwsze 2 i ostatnia spółka z listy stanowią obserwacje odstające. Portal biznesradar uznaje medianę za benchmark, czyli M dla sektora wynosi 8,66. Ponadto G = 7,1; H = 2,1. Tak niska wartość H wynika z ostatniej wartości odstającej. Im mniejsza wartość, tym więcej waży, a przecież nie o to nam chodzi. Po usunięciu 0,14 H wzrasta do 5,7, podczas gdy M do 8,86 i G do 8,5. Jeśli zaś usuniemy dwie pierwsze wartości, H spada do 1,9, a M zaledwie do 8,53, z kolei G do 5,6. Za każdym razem M była tutaj lepsza od H. Za to G była dobrą alternatywą dla M.

Żeby sensownie użyć H, musimy usunąć lewostronne obserwacje odstające. Używając G możemy na wszelki wypadek usunąć lewo- i prawostronne obserwacje.

Strategię moglibyśmy oprzeć zarówno na G jak i H. Mój pomysł byłby następujący:

- obszar poniżej H to obszar relatywnie bezpieczny,

- obszar powyżej H i poniżej G - obszar neutralny,

- obszar powyżej G - ryzykowny.

Np. kupujemy akcje o P/E równym lub mniejszym od H (tutaj 5,7), a sprzedajemy gdy znajduje się w obszarze neutralnym (tj. poniżej 8,5) lub ryzykownym (powyżej 8,5), w zależności od naszej skłonności do ryzyka.

Wg tego sposobu mamy 7 spółek do wyboru, jeśli chodzi o kupno. Możemy ograniczyć tę listę po powtórzeniu całej operacji dla innego wskaźnika, np. ceny do zysku operacyjnego. Sektor prezentuje tabela:

Źródło: https://www.biznesradar.pl/

Tym razem M = 6,1, G = 5,6, H = 3,8. Zaletą P/EBIT jest to, że dane odstające są dużo rzadsze niż dla P/E, co widać na tym przykładzie, gdzie one nie występują. Dzięki temu P/EBIT charakteryzuje większa obiektywność i w dużym stopniu eliminuje konieczność eliminowania wartości nietypowych.

Użycie H na tym zestawie pozwoliło nam zmniejszyć liczbę potencjalnych spółek do kupna z 7 do 6.

Skoro zostało nam jeszcze 6 opcji, dokonajmy dalszego filtru. Użyjmy P/BV.

Źródło: https://www.biznesradar.pl/

Wskaźnik ten jest o tyle ciekawy, że posiada już wewnętrzny punkt odniesienia, tj. P/BV = 1. Powyżej lub poniżej 1 może mieć trojakie znaczenie. Po pierwsze bilans zawiera dane zawsze opóźnione, a więc inwestorzy muszą szacować o ile rzeczywiście wartość księgowa różni się od wartości godziwej. Chodzi więc o zyski już realizowane, ale jeszcze nie wykazane w księgach. Po drugie P/BV > 1 może oznaczać, że spółka posiada większe aktywa niż to wskazuje wartość księgowa. Mogą to być zasoby intelektualne albo zdolności monopolistyczne nie uwzględnione w bilansie. Poniżej 1 na odwrót - złe zarządzanie czy niska reputacja, która generuje brak zaufania ze strony rynku. Po trzecie kapitał własny może odrywać się od ceny rynkowej poprzez ograniczenia legislacyjne dotyczące wyceny aktywów. Do 2002 r. w Polsce nie było podatków od dywidendy i zysków kapitałowych, tak że aktywa i kapitał własny były zatem wyceniane bez nich. Gdy nagle te podatki wprowadzono, nie pojawiła się zasada korekty kapitału własnego. Jednak wiele badań empirycznych dowiodło, że ceny akcji na świecie reagują spadkiem na te podatki, dlatego że teraz kupujący domagają się wyższych zwrotów, które skompensują nowe obciążenia.

Powyższa uwaga służy temu, żeby pokazać asymetrię między A i M na przykładzie P/BV. Otóż A = 1,16, a M = 0,85. Zupełnie zmienia się interpretacja rynkowego P/BV w zależności od użytej miary. Rodzi się tu pokusa, aby obydwie miary uśrednić, bo wtedy otrzymamy rzeczywiście punkt odniesienia, 1. Ale zamiast tego lepiej posłużyć się ponownie G, która równa się tutaj 1,02. Z kolei H wynosi 0,71.

Dodajemy nowy filtr dla kupna w postaci P/BV < 0,71. Okazuje się, że tylko 2 spośród wybranych 6 wcześniej spełniają to kryterium: JWW (

JWW Invest SA) oraz PAT (Patentus SA).

Oczywiście fakt, że P/BV jednej spółki jest dużo większe od innej nie oznacza, że ta pierwsza jest przewartościowana, bo może być tak, że tylko pierwsza zawiera zdolności monopolistyczne albo druga zawiera negatywne zdolności.

Aby dokonać wyboru między PAT a JWW możemy dokonać jeszcze większej restrykcji. W portalu biznesradar jest możliwość porównania tzw. P/BV Grahama, który różni się od zwykłego P/BV tym, że nie uwzględnia w wartości księgowej środków trwałych, które oczywiście są ważne (np. nieruchomości gruntowe), ale trudne do sprzedania. Trzeba też zauważyć, że środki trwałe wiążą się z większymi kosztami utrzymania niż aktywa obrotowe. Przez to wszystko ich wartość historyczna (cena nabycia) może odbiegać od rzeczywistej.

P/BV Grahama można traktować jak wskaźnik ryzyka z punktem odniesienia = 0. BV Grahama odejmuje od aktywów obrotowych zobowiązania, a więc może stać się ujemna. Jeżeli całkowite zobowiązania miałyby zostać szybko spłacone, to jedynym zabezpieczeniem przed niewypłacalnością byłyby aktywa obrotowe. Dlatego te akcje z P/BV Grahama > 0 są znacznie bezpieczniejsze. Choć zaznaczyć trzeba, że użycie zobowiązań całkowitych to duża restrykcja.

Zastosowanie P/BV Grahama przynosi poniższa tabela:

Źródło: https://www.biznesradar.pl/

Mniejsza liczba spółek na liście wynika z tego, że pozostałe mają ujemne wskaźniki. M = 2,99, G = 4,67, H = 2,1. Szybko zauważymy, że spośród 2 wyżej wskazanych spółek jedynie JWW spełnia wymagania H. Z drugiej strony PAT ma 2,8, czyli nie dużo więcej niż H i nie przekracza G.

Dla ostatecznego porównania sprawdzimy jaki jest udział zysku netto w operacyjnym cash flow tego sektora:

Źródło: https://www.biznesradar.pl/

Tym razem nie jest to wskaźnik rynkowy i im większa wartość tym lepiej. PAT posiada 120% (znacznie powyżej mediany 65%), a JWW jest trzeci od końca i jego udział jest ujemny. Ponieważ wcześniej widzieliśmy, że P/EBIT jest dla niego dodatni, to znaczy, że przepływy operacyjne są ujemne.

W końcu akcje PAT są bardziej płynne od JWW, co ma istotne znaczenie w realnym handlu.

Przedstawiona analiza wskaźnikowa to tylko przykład zastosowania bardziej precyzyjnej selekcji spółek do portfela. Najlepszym dowodem jest to, że spośród całego sektora przez wszystkie sita przeszła tylko jedna, max dwie spółki do przyszłego inwestowania.

Uwaga: powyższe dane z biznesradar.pl są sprzed tygodnia.

DODATEK:

Dlaczego średnia harmoniczna? Powróćmy do wskaźnika P/E. Jego odwrotnością jest E/P, czyli zysk do ceny (zakupu). Oznacza to, że odwrotność P/E stanowi nieopodatkowaną stopę zwrotu inwestora. (Na zysk będzie składać się dywidenda i zwrot ze sprzedaży akcji). Porównywanie stóp zwrotu jest intuicyjnie oczywiste. To procentowy zysk się liczy, a nie kurs. Dlatego mając odwrotność E/P, obliczamy z tego zwykłą średnią. Ponieważ stopa zwrotu = E/P, zapiszemy średnią:

gdzie N to liczba spółek w portfelu.

Ale ponieważ chcemy mieć uśrednioną miarę P/E, to odwracamy tę średnią, otrzymując średnią harmoniczną H:

Lub inaczej:

Mimo ogólnej intuicyjności użycie średniej harmonicznej nie jest oczywiste w podanym przykładzie. Występują jednak sytuacje, gdy staje się ona naturalna. Mianowicie chodzi o średnią szybkość.

Powiedzmy, że auto pokonuje dwa takie same odcinki drogi, ale z różną prędkością. Pierwszy odcinek pokonuje z prędkością 100 km/h, a drugi na skutek korków zaledwie 1 km/h. Jaka jest średnia prędkość pojazdu? Średnia A = 50,5 km/h , ale czujemy, że to absurd. Natomiast H = 2 / (1/100 + 1/1) = 1,98 km/h okazuje się zupełnie sensowne. Dzieje się tak dlatego, że to czas odgrywa ważniejszą rolę niż pokonana droga (tak jak zysk był ważniejszy od ceny). W pierwszej części 1 km pojazd przejechał w 0,6 minuty, podczas gdy w drugiej wlekł się w godzinę.

To że czujemy, że H lepiej odzwierciedla prawdziwą prędkość nie oznacza jeszcze, że tak jest w rzeczywistości. Wyjaśnienie jest jednak dość proste: gdy mowa o średniej prędkości tego samego pojazdu w określonym przedziale czasu, to oba odcinki drogi nie traktujemy wcale jako niezależne od siebie. Najpierw jest jeden odcinek, potem drugi, ale razem tworzą całość. Tak samo oba okresy stanowią całość. Mówiąc inaczej, zarówno drogę (D), jak i czas (T) możemy zsumować. Właściwa średnia powinna odzwierciedlać pokonanie całkowitej drogi w całkowitym czasie. A to okazuje się właśnie średnią harmoniczną:

Ponieważ prędkość V = D / T, to T = D / V:

W ogólnym przypadku: