Jeżeli mamy przeciętnego przedsiębiorcę, to zapewne nie będzie się zbyt długo nad tym zastanawiał - po prostu pochodzi po ulicach, przejrzy anonse, czyli sprawdzi jaka jest cena rynkowa i biorąc czy to średnią, czy średnią + odchylenie standardowe (jeśli uważa, że jego produkt jest wart więcej niż tylko średnia), wyceni swój produkt. Następnie skalkuluje roczne koszty i na ich podstawie sprawdzi czy inwestycja jest opłacalna. Obliczenie marży nie będzie dla niego problemem. Taki przedsiębiorca nie musi studiować ekonomii, aby oszacować cenę i rentowność sprzedaży.

Ale powyższy wywód jest tautologią: skoro z założenia ktoś jest przeciętnym przedsiębiorcą, to nie może wyceniać dobra więcej niż to robi rynek. Trudniej mają ci nieprzeciętni, którzy mają zamiar wejść na rynek z nowym, innowacyjnym produktem albo produktem o lepszej jakości. Z pomocą przychodzi tu mikroekonomia.

Opiszę zagadnienie w 5 punktach.

1) Przedsięwzięcie jest opłacalne, gdy przychody (iloczyn ilości dobra i jego ceny) minus koszty są większe od zera. Oznaczając p - cena danego dobra, y - ilość sprzedawanego dobra, c - koszty poniesione na wytworzenie i sprzedanie dobra w danym okresie, możemy zapisać:

gdzie AC (average cost) - koszt średni albo przeciętny.

Widzimy więc, że podstawową zasadą opłacalności inwestycji jest to, aby cena produktu czy usługi była większa od kosztu przeciętnego. Pierwsze co trzeba zrobić, to oszacować mniej więcej koszty i podzielić przez ilość dobra, jaką prognozujmy sprzedać w danym okresie. Trzeba tu zauważyć, że ten model odnosi się do konkretnego okresu czasu. Załóżmy, że początkowe nakłady inwestycyjne ponoszone są w 2016 r., a sprzedaż i koszty uzyskanego przychodu, tylko w roku 2017. Oznacza to, że za c podstawiamy tylko koszty z roku 2017. Właściwie można powiedzieć, że model dokładnie odzwierciedla zasady księgowości, jak zasada współmierności kosztów i przychodów oraz zasada memoriałowa. Musimy więc brać pod uwagę także amortyzację - gdyż jest to często koszt rozłożony w czasie. Ciekawe zagadnienie pojawia się, gdy zastanawiamy się nad kosztami czysto ekonomicznymi, jak koszt czasu i ryzyka. Uwzględniać czy nie uwzględniać? W tej materii musimy się spytać o jaką opłacalność inwestycji chodzi? Księgową, pieniężną, a może czysto ekonomiczną? Jeśli badamy opłacalność pieniężną, to nie mamy już do czynienia z kosztami, ale wydatkami, czyli badamy przepływy pieniężne. Jeśli natomiast badamy przedsięwzięcie bardzo szeroko, czyli jego efektywność ekonomiczną, to bierzemy też koszt czasu, ponoszonego ryzyka i efekty zewnętrzne (jak np. zanieczyszczenie środowiska, hałas i wszystko inne co obniża dobrobyt społeczny). W konsekwencji zysk ekonomiczny może być zerowy albo bardzo bliski zera. Mimo to księgowo albo pieniężnie inwestycja może być bardzo opłacalna. Na pewno warto sobie zrobić taką ocenę projektu z 3 różnych płaszczyzn. Trzeba jednak pamiętać, że rozpatrywane koszty (albo wydatki w formie przepływów pieniężnych) dotyczą tylko tego jednego dobra - jeśli produkujemy 2 różne dobra, to koszty dotyczące 2-go dobra muszą zostać odpowiednio odjęte.

2) Ten sam model zapiszmy dokładniej, tzn. jako równanie przychody - koszty = zysk i od razu przekształćmy

gdzie z - zysk, M - marża netto (rentowność sprzedaży) równa zysk/przychody.

Otrzymaliśmy ciekawy wzór na cenę produktu: jest ona równa kosztowi przeciętnemu podzielonemu przez (1 - marża netto).

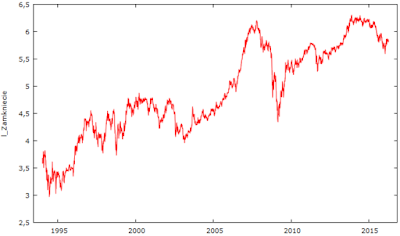

Cenę warunkuje więc marża, ale ile powinna ona wynieść? Można to rozwiązać na co najmniej 2 sposoby. Po pierwsze można skorzystać z danych historycznych. Najłatwiej dostępne są dane dla rynku amerykańskiego, np. dla S&P 500. Poniżej zamieszczone dane zasięgnąłem ze strony http://www.multpl.com/. Aby uzyskać marżę, inaczej wskaźnik ROS (return on sales), podzieliłem wskaźnik cena/przychód przez cena/zysk dla lat 2000-2016.

Średnia marża = 6,87%, dominanta = ok. 7,7%.

Ta zgrubna metoda może i jest dość dobrym punktem wyjścia, jednak dla przedsiębiorcy z dużym potencjałem wzrostu sprzedaży, może być nieprzydatna. Dlatego dobrze też użyć drugiej metody. Aby ją zastosować, potrzebny jest trzeci punkt analizy.

3) Dotychczas nie zakładaliśmy, że przedsiębiorca chce osiągnąć jak najwyższy zysk. Dopiero to założenie pozwoli wyznaczyć cenę i marżę. Z maksymalizacją funkcji zysku wiąże się wiele problemów. Pierwsze to oczywiście takie, względem czego maksymalizować zysk? Mamy przecież 3 zmienne: cenę, ilość dobra i koszty. Moglibyśmy próbować maksymalizować zysk względem każdej zmiennej. Powiedzmy, że maksymalizujemy względem ceny. Wiadomo, że cena nie może być zbyt niska, bo zarobimy mniej niż byśmy mogli, ani zbyt wysoka, bo za mało chętnych osób kupi produkt. To podejście jest ciekawe, ale musielibyśmy znać zależność funkcyjną popytu od ceny. Musielibyśmy wiedzieć, jak y zmieni się w zależności od p. Jeżeli przedsiębiorca wchodzi z nowym produktem czy usługą na rynek, to mógłby zrobić pewne badania rynkowe, ankiety itd. Ale to też kosztuje. Łatwiej zacząć od zmiennych, które dobrze znamy i którymi możemy kalibrować. Zamiast od strony popytu, zacznijmy od strony podaży - oceniamy co się stanie, gdy nieco zmienimy y. Zakładamy, że zmienne są funkcjami zależnymi od y. Dostajemy:

Zgodnie z rachunkiem różniczkowym, jeśli funkcja ma ekstremum, to warunkiem koniecznym jest, aby pierwsza pochodna po y równała się 0. Od razu też przekształćmy:

gdzie MC (marginal cost) to koszt krańcowy, który mówi ile zmieni się koszt całkowity (ale tylko ten związany z dobrem y) na skutek niewielkiej zmiany w produkcji dobra (lub dostarczeniu usługi). Ponieważ produkt ze swojej natury jest liczony w jednostkach naturalnych, to ta niewielka zmiana produkcji będzie po prostu oznaczać 1 dodatkową jednostkę produktu. Jeżeli produkujemy o 1 jednostkę więcej, to być może potrzebujemy zużyć do tego więcej materiału, zatrudnić dodatkowego człowieka itp. Suma tych nowych kosztów to właśnie MC.

Jeżeli cena p zależy od y, to zgodnie z twierdzeniami na pochodnych - przekształcając przedostatnie równanie - dostaniemy:

Ostatnim elementem poszukiwania maksimum zysku byłoby sprawdzenie czy druga pochodna funkcji zysku jest ujemna, tzn. czy nachylenie tej funkcji spada, gdy wyprodukujemy nieco więcej dobra. Żeby zysk osiągnął maksimum, to zanim go osiągnie, musi rosnąć coraz wolniej. Okazuje, że przy całkiem naturalnych założeniach, tak właśnie się dzieje. Dowód opisałem w Dodatku*.

I to już koniec matematyki wyższej. Reszta to zwykłe przekształcenie:

W nawiasie kwadratowym dostaliśmy coś interesującego: procentową zmianę ceny na skutek procentowej zmiany ilości dobra. Jak wyżej stwierdziłem interesuje nas mała zmiana y. Powiedzmy, że w przybliżeniu:

Możemy również spokojnie pozwolić sobie na zapis:

Wtedy dostaniemy:

Takie rozpatrywanie sprawy jest kłopotliwe. Czy zwiększenie / zmniejszenie produkcji wywoła w nas motywację do zmian ceny? Jeśli trafiamy na jakieś przeszkody w produkcji, tak że nasze zasoby stają się ograniczone, to z jednej strony chcielibyśmy podnieść cenę, aby skompensować mniejsze zyski (jeżeli podaż dobra spada, to jego cena rośnie). Ale z drugiej strony, jeżeli mniej produkujemy, to koszty spadają, co ogranicza spadek zysków.

Lub na odwrót - jeśli chcemy więcej sprzedać, to powinniśmy obniżyć cenę. Ale jeśli więcej produkujemy, to podnosimy też koszty, które ograniczają zyski.

W konsekwencji cena może w ogóle się nie zmienić albo zmienić się nieznacząco. W takiej sytuacji cena będzie równa kosztowi krańcowemu: p = MC. Cena stanowiłaby dodatkowy koszt, który powstaje w wyniku zwiększenia produkcji o jednostkę.

4) W końcu połączmy wzór na cenę z punktu (2) z ostatnim wzorem na cenę z punktu (3) i stąd odnajdziemy wzór na M:

Odpowiedź na tytułowe pytanie znaleźliśmy. Newralgicznym punktem pozostaje r. Rozwiązemy ten problem w p. 5.

5) Przy analizie rentowności dobrym pomysłem jest wykorzystanie ROE lub ROA, których odwrotność można interpretować jako okres, po jakim zwraca się inwestycja (pokazuje bowiem ile jednostek zysku mieści się w kapitale, przez który się dzieli, a liczba tych jednostek odpowiada liczbie okresów finansowych). Np. jeżeli ROE = 10%, to znaczy, że inwestycja zwróci się po 10 latach, a jeżeli 20%, to po 5 latach (zysk po tylu latach zwróci zainwestowany kapitał). Łatwo zauważyć też, że

Podstawiamy ten wzór do wzoru w p. 4:

Rozwiązujemy to równanie względem p:

5a)

Wykorzystując wzór z p. 3, wiemy, że cena = MC / (1+r) i podstawiając go do powyższego:

Rozwiązujemy to równanie względem r:

Wykorzystując wzór z p. 3, wiemy, że cena = MC / (1+r) i podstawiając go do powyższego:

Rozwiązujemy to równanie względem r:

5b)

Zatem otrzymaliśmy wpływ zmiany produkcji na zmianę ceny lub na odwrót. Podstawiamy prawą stronę (5b) do (5a) i rozwiązujemy względem p:

5c)

Zauważmy, że pozbyliśmy się ze wzoru (5c) zarówno kosztu krańcowego (MC) jak i marży (M). Otrzymaliśmy bardzo prosty wzór, ponieważ koszt przeciętny (tj. koszty całkowite podzielone na wielkość produkcji danego roku) powinniśmy potrafić oszacować, kapitał własny (WK) znamy, a ROE szacujemy w ten sposób, że odpowiadamy sobie na pytanie, po ilu latach najpóźniej chcemy, aby w całości zwrócił się WK.

5c)

Jeżeli inwestycję finansujemy także kapitałem obcym, to dla szerszej perspektywy, warto użyć ROA w miejsce ROE:

5d)

gdzie

ROA = oczekiwany zysk w danym roku /Aktywa,

A - Zainwestowane aktywa, tj. kapitał własny + dług.

Oczywiście jest to to samo, ale tym razem szacujemy po ilu najpóźniej latach spodziewamy się, że zarówno dług jak i kapitał własny zwróci się w całości. Jednakże, jeżeli znamy ROE, to nie jest nawet konieczne:

Oczywiście jest to to samo, ale tym razem szacujemy po ilu najpóźniej latach spodziewamy się, że zarówno dług jak i kapitał własny zwróci się w całości. Jednakże, jeżeli znamy ROE, to nie jest nawet konieczne:

Przykład:

Chcemy oszacować cenę produktu. Robimy to w trzech etapach:

Etap 1. Szacujemy, że całkowite koszty, jakie poniesiemy w tym roku to ok. 50 000. Chcielibyśmy sprzedać średnio 10 sztuk towaru dziennie, czyli ok. 3650 w roku. Cały kapitał własny, jaki zainwestowaliśmy to 30 000 (reszta to kredyty). Chcielibyśmy, żeby ten kapitał zwrócił się po 3 latach. To znaczy, że ROE = 1/3 = 33%. Podstawiamy dane do (5c):

p = 50000 / 3650 + 0,33*30000 / 3650 = 16,4.

Etap 2. Powiedzmy, że nie znamy ROE. Szacujemy, że cały kapitał (dług + kapitał własny) zwróci się po 4 latach. Stąd ROA = 1/4 = 25%. Kredyty = 25 000, stąd A = 55 000. Wobec tego podstawiamy do (5d):

p = 50000 / 3650 + 0,25*55000 / 3650 = 17,5.

Etap 3. Wyciągamy średnią: (16,4 + 17,5)/2 = 16,95.

W ten sposób ustalamy cenę produktu na poziomie ok. 17. Oczywiście zamiast średniej możemy ustalić dowolną wartość w przedziale 16-17.

*DODATEK

Warunek konieczny i wystarczający dla maksymalnego zysku może zostać spełniony dla wielu modeli zarówno liniowych, jak i nieliniowych. Zanim podzielimy problem na te dwa przypadki, to spostrzeżemy jedną rzecz. Mianowicie, całkiem rozsądne jest, że gdy trochę więcej produkujemy, to cenę produktu obniżamy: jeżeli jestem zmotywowany, by sprzedać więcej dobra, to powinienem obniżyć jego cenę (czyli pierwsza pochodna ceny jest ujemna).

(1) Nieliniowe modele.

Mogę tak robić, dopóki koszty mi nie przeszkadzają. Jednak z czasem koszty mogą mocno ograniczać moje możliwości. Im większa skala produkcji, tym więcej problemów, potrzebne są nowe budynki, nowi menedżerowie, a ponadto jeśli zależy mi na zatrudnianiu nowych pracowników, to popyt na pracę będzie zmuszał do podnoszenia wynagrodzenia. To wszystko razem będzie generowało coraz wyższe koszty krańcowe (gdyby tego skumulowanego efektu nie było, koszty całkowite by rosły, ale koszty krańcowe stałyby w miejscu).

Prowadzi to do wniosku, że z jednej strony cena na skutek zmian produkcji powinna spadać coraz wolniej (a być może nawet od jakiegoś punktu zacząć rosnąć) i zachowywać się np. jak funkcja p(y) = 10*y^(-1/2):

Wtedy jej pierwsza pochodna będzie funkcją -5*y^(-3/2):

Druga pochodna ceny po y ma wtedy postać 15/(2 y^(5/2)):

Widać, że druga pochodna jest dodatnia. Ma to istotne znaczenie dla znalezienia maksimum zysku.

Z drugiej strony - zgodnie z powyższą analizą - koszty całkowite będą rosły coraz szybciej, np. niech c = 2y^(3/2):

A wtedy koszty krańcowe muszą rosnąć. Dla przykładowej funkcji c dostaniemy MC(y) = 3y^(1/2):

Druga pochodna kosztów c po y ma postać 3/(2y^0.5):

Teraz łatwo zobaczyć, że istnieje maksimum zysku.

Pokażmy to rachunkowo, po kolei:

Pierwsza pochodna po y:

gdzie MP(y) to krańcowy zysk (marginal profit). Warunkiem koniecznym maksimum jest aby:

Dla ułatwienia oznaczmy:

Warunkiem wystarczającym istnienia maksimum jest, aby druga pochodna funkcji zysku po y była mniejsza od zera:

Załóżmy prostszą sytuację, że po pierwsze cena spada liniowo, np. p = 14 - 3y. W tej sytuacji s = -3 oraz druga pochodna = 0. Po drugie, że koszty rosną liniowo, np. c = 2y. Wtedy MC = 2, ale druga pochodna = 0. Wtedy warunek konieczny to p - 3y = 2. Znów rozwiązujemy układ równań:

Warunek wystarczający to 2*(-3) + 0 < 0 jest zawsze spełniony, więc istnieje maksimum.

Chociaż warunek wystarczający zostanie spełniony zawsze dla liniowych modeli (jeśli tylko r < 0), to z warunkiem koniecznym jest już trudniej. Np. jeśli c = 20y oraz p = 14 - 3y, to y = -1, a więc produkcja powinna wynieść co najwyżej 0, czyli najbardziej opłacalne byłoby nie prowadzić działalności.