Klasyczna formuła na semi-wariancję z próby to

gdzie

r(t) - stopa zwrotu

R - oczekiwana stopa zwrotu (średnia)

T - liczba obserwacji.

Mechanizm jest prosty: jeśli różnica między stopą zwrotu a średnią jest dodatnia, wtedy odrzucamy ją i zastępujemy zerem. Jeśli jest ujemna, wtedy przyjmujemy ją i podnosimy do kwadratu.

Ze względu na występujące zera SV zawsze będzie mniejsza od wariancji. Gdy mamy do czynienia z rozkładem symetrycznym, wariancja będzie dwa razy większa od SV (dla której zera będą się symetrycznie rozkładać z nie-zerami). Żeby więc sprawdzić symetryczność rozkładu, można podwoić SV i sprawdzić czy jest bliska wariancji.

Jeżeli jednak chcemy stworzyć miarę ryzyka związaną z potencjalną stratą, to nie możemy użyć SV, bo r(t) < R nie oznacza jeszcze straty. Dlatego w miejsce R możemy wstawić zero:

Taka miara ryzyka jest już sensowna, ale ciągle ze względu na występujące zera będzie zaniżać całkowitą stratę - w końcu dzielimy sumę przez liczbę wszystkich obserwacji (a więc też z zerami). Dla dużej liczby danych zastosowałbym miarę uwzględniającą tylko straty:

Aby uzyskać średnią stratę, wyciągniemy pierwiastek kwadratowy:

Powiedzmy, że mamy kapitał początkowy K. Przewidujemy, że w kolejnych okresach może się zdarzyć średnia strata S. Stratę zapiszemy jako procentowe pseudo-semi-odchylenie standardowe, SDs, przemnożone przez K:

(1)

Wymagamy, aby w następnych okresach oczekiwany zysk wyniósł co najmniej S, aby wyrównać stratę. Ktoś powie, że nie możemy czegoś wymagać od rynku. Nie możemy sami, ale jako zbiorowość inwestorów już tak. Zakładamy, że wszyscy inwestorzy mają takie samo minimalne wymaganie. Będzie to oznaczało, że oczekiwana stopa zwrotu (równa stopie dyskontowej - to znaczy, że kapitał jest odpowiednio dyskontowany, tak aby w przyszłości mógł wzrosnąć - na tym polega idea wymaganej stopy zwrotu; jeśli ktoś ma tu wątpliwości, niech przeczyta mój komentarz do poprzedniego artykułu, gdzie szczegółowo wyjaśniłem ten problem) będzie równa:

(2)

Zgodnie z CAPM-CML stopa zwrotu z portfela to kombinacja liniowa stopy wolnej od ryzyka (systematycznego), Rf, i stopy zwrotu z portfela rynkowego, R(M):

(3)

gdzie x to udział instrumentu bez ryzyka, zaś 1-x to udział portfela rynkowego w całym portfelu.

Podstawiamy (2) do (3):

(4)

Rozwiązujemy (4) względem x:

(5)

Klasyczna postać CAPM-CML to:

(6)

gdzie:

D - odchylenie standardowe portfela inwestora

D(M) - odchylenie standardowe portfela rynkowego

Aby dopasować CML do naszego modelu, w miejsce D i D(M) w (6) wstawimy SDs i SD(M)s:

(7)

Za Rp wstawiamy uzyskany wynik w (2):

(8)

Rozwiązujemy to równanie względem SDs. Dostaniemy 2 rozwiązania, wśród których jedno jest ujemne - odrzucamy je. Pozytywne rozwiązanie podstawiamy do równania (5) na x. Ze względu na dwa rozwiązania SDs ogólnie dostaniemy też dwa rozwiązania względem x:

x1 = -(Rf - Rm + SD(M) - Rf*SD(M) + 2*Rm*SD(M) - (Rf^2*SD(M)^2 - 2*Rf^2*SD(M) + Rf^2 + 2*Rf*Rm*SD(M) - 2*Rf*Rm + 2*Rf*SD(M)^2 + 2*Rf*SD(M) + Rm^2 - 2*Rm*SD(M) + SD(M)^2)^(1/2))/(2*SD(M)*(Rf - Rm))

x2 = -(Rf - Rm + SD(M) - Rf*SD(M) + 2*Rm*SD(M) + (Rf^2*SD(M)^2 - 2*Rf^2*SD(M) + Rf^2 + 2*Rf*Rm*SD(M) - 2*Rf*Rm + 2*Rf*SD(M)^2 + 2*Rf*SD(M) + Rm^2 - 2*Rm*SD(M) + SD(M)^2)^(1/2))/(2*SD(M)*(Rf - Rm))

Poprawne rozwiązanie wynikać będzie z dodatniego rozwiązania SDs. Ale tak naprawdę nie trzeba tego podstawiać do x, wystarczy, że spośród tych dwu powyższych rozwiązań jedno będzie dodatnim ułamkiem (będzie jednocześnie posiadać dodatnie SD). Drugie odrzucamy.

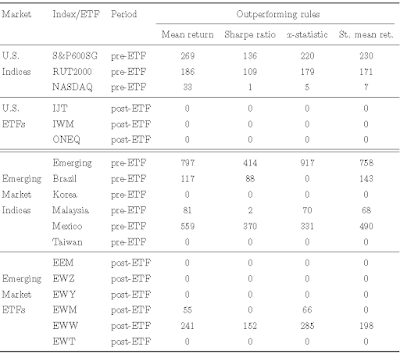

Przykład 1.

S&P 500 w okresie 1941-2017 posiada średnią stopę zwrotu 8,7%, odchylenie standardowe D(M) = 16,3%, a SD(M)s = 16,1%. Chociaż D(M) jest praktycznie równe SD(M)s, to pamiętajmy, że nie oznacza to symetryczności rozkładu. Popatrzmy zresztą na histogram stóp zwrotu:

Mamy tu lewostronną skośność - oznacza to, że semi-wariancja lewostronna jest większa od semi-wariancji prawostronnej. Jednak straty nie są wcale większe od zysków - zauważmy, że dominanta wynosi 13,7% (częstość = 19). Czyli większa masa kumuluje się po stronie zysków. Istnieje wprawdzie gruby ogon na stratach, ok -38%, ale występuje więcej obserwacji powyżej 0.

Paradoksalnie więc możemy stosować zwykłe odchylenie standardowe, które okazuje się zbliżone do średniej straty. Czyli wiemy, co podstawić pod Rm i SD(M)s. Ale pytanie co podstawić pod Rf? Zwracam uwagę, że Rm = 8,7% to średnia arytmetyczna. Z poprzedniego artykułu wiemy, że trzeba w takiej sytuacji stosować krótkoterminowe stopy zwrotu, a więc także krótkoterminową rentowność obligacji skarbowych, a ściślej mówiąc 1-roczną. Na podstawie http://www.multpl.com/1-year-treasury-rate/ możemy uzyskać dokładne dane statystyczne. Obecnie 1-roczna stopa z obligacji skarbowych USA wynosi 2,24%. Jednakże operujemy średnimi i sztucznie byłoby zastosować bieżącą rentowność - mimo iż stosowane stopy do CAPM powinny określać przyszłość a nie przeszłość. W dodatku stopy rentowności okazują się niestacjonarne, co dodatkowo komplikuje analizę. Nie bądźmy jednak zbyt pedantyczni. Portal Shillera stwierdza, że średnia rentowność to 3,08%, więc przyjmijmy 2,5% oraz 3%. Dlaczego 2,5%? Pamiętajmy, że skoro operujemy krótkoterminową roczną średnią, to znaczy, że są to oczekiwania na rok naprzód - a przecież rentowność nie wzrośnie w ciągu roku o nie wiadomo ile. Dlatego przyjmiemy te dwa przykładowe poziomy.

W sumie podstawimy do rozwiązania na x1 i x2 następujące dane:

Rm = 8,7%

SD(M) = 16,1%

Rf = 2,5% lub 3%

Dostaniemy:

*Dla Rf = 2,5%:

x1 = 0,76

x2 = 11,56

x2 odrzucamy, czyli właściwy udział portfela rynkowego w całym portfelu to 1-x = 1-0,76 = 24%.

*Dla Rf = 3%:

x1 = 0,73

x2 = 13,13

Ponownie przyjmujemy x1, czyli udział portfela rynkowego w portfelu to 1-x = 1-0,73 = 27%.

Łącznie dostajemy przedział 25-30% minimalnego udziału portfela rynkowego w portfelu.

W kolejnych przykładach będę odrzucał błędne rozwiązania.

Przykład 2. WIG: 1997-2017.

Średnia stopa zwrotu WIG wyniosła 10,6%, odchylenie standardowe 25,4%, a SDs = 27,5%. Ponieważ:

a) można powiedzieć, że również dla polskiego indeksu odchylenie standardowe jest zbliżone do średniej straty,

b) dla Polski całkowita liczba danych to 21, a do obliczenia SD(M)s posłużyło zaledwie 6 danych (bo tylko 6 lat w ciągu tych 21 było ujemnych...),

to rozsądne jest zastąpić tutaj SD(M)s samym odchyleniem standardowym, D(M).

Teraz kwestia Rf. Krótkoterminowe obligacje skarbowe obecnie są nieopłacalne, skoro proponują ledwo ponad 2%. Banki proponują 2,5-3%. Ponieważ średnia jest większa, przyjmę dla Polski Rf = 3% i 3,5%.

W sumie podstawiamy:

Rm = 10,6%

SD(M) = 25,4%

Rf = 3% lub 3,5%

Dostaniemy:

*Dla Rf = 3%:

x = 0,84

*Dla Rf = 3,5%:

x = 0,82

Zatem dla pierwszego przypadku udział indeksu w portfelu powinien wynieść 1-0,84 = 16%, a dla drugiego przypadku 1-0,82 = 18%.

Z tego przykładu wynika, że powinniśmy trzymać WIG w proporcji 15-20% w stosunku do aktywów bez ryzyka rynkowego.

Przykład 3. Teoretyczny portfel akcji.

Model można uogólnić w ten sposób, że zamiast indeksu, przyjmiemy własny portfel akcji, który uważamy za lepszy od samego indeksu. Wtedy za Rm i SD(M) podstawiamy Rw i SD(W) - odpowiednio oczekiwaną stopę zwrotu z portfela akcji (albo innych ryzykownych aktywów) i średnią potencjalną stratę z tego portfela. Te wielkości podstawiamy do wzoru na x.

Powiedzmy, że znaleźliśmy portfel akcji, który daje Rw = 15% i SD(W) = 20%. Wtedy, przy założeniu Rf = 3%, uzyskamy x = 68%, czyli posiadając tak dobre akcje, powinniśmy je trzymać w udziale co najmniej 32%. Z kolei dla Rw = 15% i SD(W) = 25%, poziom ten spada do 1-x = 21%.

Gdyby natomiast Rw = SD(W), tj. oczekiwany zysk portfela akcji zrównałby się ze średnią stratą z tego portfela, oraz

* Rw = 10%, to 1-x = 78%,

* Rw = 15%, to 1-x = 65%,

* Rw = 20%, to 1-x = 55%,

* Rw = 25%, to 1-x = 47%.

Podsumowanie:

Z teorii finansów wynika, że portfel rynkowy jest najbardziej zdywersyfikowanym portfelem wśród portfeli ryzykownych, tzn. ma najniższe ryzyko przy danym poziomie oczekiwanego zysku. Portfel rynkowy przybliżamy najczęściej indeksem giełdowym. Stąd inwestor posiada początkowo dwie skrajne możliwości: inwestowanie bez ryzyka albo w indeks giełdowy. Spośród tych dwóch skrajności może wybrać koszyk pośredni. Jeśli będzie chciał trzymać portfel akcji tylko w takiej proporcji, aby potencjalna strata została skompensowana przez oczekiwany zysk, to uzyska pożądany udział portfela, stosując przedstawiony wzór na x.

Jeśli za portfel rynkowy uzna indeks USA, to powinien trzymać 25-30% tego indeksu. Jeśli przyjmie WIG, to powinien go trzymać w udziale 15-20%.

Wiemy jednak obecnie, że klasyczna teoria finansów nie wystarcza. Dlatego inwestor ma szansę znaleźć lepsze, choć bardziej skomplikowane portfele akcji niż indeks. Gdyby znalazł taki, co ma odchylenie standardowe takie samo jak WIG (tj. 25%), ale oczekiwaną stopę zwrotu nie 11, a 15%, to jego udział powinien wynieść 20%. Gdyby udało mu się zmniejszyć jeszcze to odchylenie do 20%, to udział powinien wzrosnąć do 32% (przy Rf = 3%.). W sumie można więc powiedzieć, że minimalny udział akcji w portfelu inwestora powinien się mieścić między 15 a 30%.

P. S. Zasada Pareto 20:80? Do przemyślenia...