CAPM zarówno swoją nazwą (Capital Asset Pricing Model to po polsku model wyceny aktywów kapitałowych) jak i istotą nawiązuje do wyceny akcji, więc tytułowe pytanie wydaje się bez sensu. W rzeczywistości model ten nie wyznacza bezpośrednio wartości wewnętrznej akcji, lecz właściwą oczekiwaną stopę zwrotu dowolnego aktywa kapitałowego (aktywom o określonym ryzyku rynkowym musi towarzyszyć odpowiednia oczekiwana stopa zwrotu). Zbyt wysoka oczekiwana stopa zwrotu w stosunku do ryzyka sprawi, że cena akcji szybko pójdzie w górę. Akcje znajdują się bowiem powyżej SML, a skoro cena wzrośnie, to oczekiwany zysk spadnie, a więc akcje powrócą na SML. Z kolei zbyt niska oczekiwana stopa zwrotu spowoduje, że cena szybko spadnie. Wtedy akcje znajdują się poniżej SML, a skoro cena spadnie, to oczekiwany zysk wzrośnie, a więc akcje powrócą na SML.

Fakt - CAPM można w takim sensie użyć jako narzędzie do wyceny akcji. Jednak rodzą się problemy w ogólniejszych przypadkach. W sytuacji gdy spółka dopiero co została założona lub gdy akcje dopiero co wchodzą na giełdę nie ma możliwości użycia CAPM. Innym kłopotem jest sytuacja, gdy spółka jest młoda i znajduje się w fazie ekspansji, a także gdy następują jakieś bardzo istotne fundamentalnie zmiany dla spółki - wtedy liczy się przede wszystkim analiza fundamentalna. Nawet w tych przypadkach nie wolno lekceważyć CAPM, ponieważ obecnie naukowcy pracują nad coraz bardziej zaawansowanymi rozszerzeniami i uogólnieniami tegoż modelu. Niemniej wszelkie niuanse i subtelności w zmianach wyceny mogą jedynie zostać odkryte w toku analizy fundamentalnej.

W sytuacji, gdy spółka wypłaca dywidendy i oczekuje się, że będą one rosły w średnim tempie g, wtedy możemy zastosować model wyceny Gordona:

gdzie:

P(0) - obecna wartość wewnętrzna akcji

D(1) - oczekiwana dywidenda w okresie 1

r - wymagana stopa zwrotu przez akcjonariusza (koszt kapitału własnego)

g - oczekiwana stopa wzrostu dywidendy

Krytycy tego prostego modelu przekonują, że jest on nieprzydatny, ponieważ istnieje zbyt duża niepewność co do przyszłości nawet stabilnej firmy; zmienność i cykliczność otoczenia gospodarczego nie pozwala wyznaczyć precyzyjnie wartości, natomiast inwestorzy różnią się znacznie oczekiwaniami na temat przyszłych zysków. Ponadto nawet niewielkie różnice pomiędzy tempem wzrostu zysku/dywidendy a kosztem kapitału własnego powodują silne zmiany w wycenie. Koszt kapitału własnego jest pojęciem abstrakcyjnym, umownym, ponieważ jego oszacowanie jest często intuicyjne. Powyższej krytyce można przeciwstawić 5 kontrargumentów.

Po pierwsze budowa modelu wyceny nie polega na znajomości przyszłości, lecz na posiadaniu racjonalnych oczekiwań. Racjonalne oczekiwania są często błędnie rozumiane przez inwestorów. Na przykład uważają, że wartość wewnętrzna powinna odzwierciedlać oczekiwania (prognozy) zarządu spółki lub też ich własne optymistyczne oczekiwania. W rzeczywistości rynek ocenia wartość obiektywnie, a więc uśrednia pesymistyczne i optymistyczne założenia. Oczywiście optymistyczne założenia będą mieć większą wagę, jeśli spółka dobrze sobie radziła w przeszłości.

Po drugie w psychologii, a także w ekonomii behawioralnej dobrze znane jest zjawisko regresji do średniej. Z tego punktu widzenia optymistyczne założenia, że firma będzie się rozwijać szybciej niż rynek, nie mogą być odpowiednie w długim okresie czasu, ponieważ należy założyć zbieżność do tempa rynku. Mogą przy tym istnieć pewne wyjątki, jeśli np. spółka ma już dziś przewagę monopolistyczną i jest w stanie ją utrzymać. Podobnie w drugą stronę - jeśli firma w najbliższym czasie będzie się wolniej rozwijać od rynku, to w dalszych okresach powinniśmy uwzględnić powrót do średniej. Mogą istnieć wyjątki także w tej sytuacji, np. jeśli zarząd ewidentnie niszczy wartość firmy lub jest strukturalnie nieefektywny.

Obok zjawiska regresji do średniej, można także zasygnalizować "działanie" prawa wielkich liczb. Zgodnie z tym prawem średnia z próby dąży wraz ze wzrostem liczebności próby do średniej z populacji. Prawo regresji do średniej nie jest prawem wielkich liczb. To pierwsze prawo jest prawem "natury", z kolei drugie - prawem matematyki.

Po trzecie bardzo ważny jest wyraz D(1) w modelu Gordona. To dzięki niemu możemy kalibrować zmianą wyceny. Wydaje się rozsądne założenie, że o ile dywidendy w okresach dalszych mogą rosnąć w średnim tempie g, o tyle dywidenda w okresie 1 może być dość dokładnie oszacowana, ponieważ zysk w okresie 1 można prognozować w oparciu o przeszłe i bieżące informacje.

Po czwarte racjonalny inwestor musi "chronić się" przed zbyt dużą niepewnością przyszłego wzrostu zysku firmy tak samo jak chroni się przed skutkami inflacji. Jeśli inflacja wzrasta, to będzie on wymagał większego zwrotu skorygowanego o stopę inflacji. Podobnie dzieje się, gdy firma potrafi zwiększyć tempo wzrostu zysku wykorzystując zwiększoną rentowność kapitału własnego. Inwestor w takiej sytuacji także musi zwiększyć wymaganą stopę zwrotu, ponieważ rodzi się niepewność, że ROE powróci do średniej po jakimś czasie. Z drugiej jednak strony nie wie jak oszacować takie ryzyko, bo nie ma na czym się oprzeć. Dlatego koszt kapitału własnego rośnie, ale nie aż tak mocno jak tempo wzrostu zysku (ani więc samo ROE). Kwestia ile dokładnie wzrośnie jest rzeczywiście złożona, ale tematem tym należałoby się zająć oddzielnie. Tak czy inaczej inwestor nie pozwoli, aby różnica pomiędzy r a g stała się nagle zbyt mała.

Po piąte siła wymienionych argumentów pozwala także wykorzystać prosty CAPM, który precyzyjnie wyznacza oczekiwaną stopę zwrotu. Ponieważ oczekiwana stopa zwrotu = wymagana stopa zwrotu akcjonariusza = koszt kapitału akcjonariusza, to teza o tym, że koszt kapitału własnego stanowi zbyt niejasną koncepcję traci rację bytu - nawet jeśli spółka nie była dotąd notowana na giełdzie, to do obliczenia wymaganej stopy zwrotu możemy wykorzystać dane statystyczne dotyczące spółki podobnej, ale notowanej na giełdzie zgodnie z twierdzeniem, że w długim okresie oczekiwana stopa zwrotu zbiega do średniej (w tym przypadku dla danej branży). Większy problem powstaje dla spółki o zupełnie nowym profilu czy zupełnie nowej branży nieobecnej na rynku. W tym przypadku ryzyko jest na tyle duże, że należy po prostu potraktować wartość księgową kapitału własnego jako wartość wewnętrzną, co spowoduje, że wymagana stopa zwrotu będzie bliska ROE. Większy problem powstaje w sytuacji, gdy spółka już istnieje jakiś czas na rynku, nie jest notowana na giełdzie i jednocześnie stosunek zadłużenia do kapitału własnego znacznie się różni od średniej ze spółek w branży. Wielkość zadłużenia wpływa bowiem na koszt kapitału własnego. Niektórzy próbują rozwiązać to zagdnienie wykorzystując tzw. równanie Hamady. Niestety podejście to zazwyczaj błąd, gdyż aby stosować r. Hamady trzeba rozumieć skąd ono wynika. Najlepsze rozwiązanie tego problemu polega na tym, aby

(a) obliczyć koszt kapitału dla branży lub spółki podobnej za pomocą CAPM ,

(b) obliczyć stosunek [ROE(dla danej spółki) / ROE(dla branży lub spółki podobnej) ]

(c) przemnożyć (a) przez (b).

Tak więc CAPM można włączyć do modelu wyceny dla każdej akcji. Przypomnijmy wzór CAPM-SML:

μ(i) - oczekiwana stopa zwrotu waloru i

Rf - stopa wolna od ryzyka rynkowego

beta(i) - ryzyko rynkowe waloru i

μ(M) - oczekiwana stopa zwrotu z portfela rynkowego (M)

Do wyceny wykorzystujemy prosty CAPM, ponieważ interesuje nas tylko uśredniona oczekiwana przyszłość wzrostu akcji. Koszt kapitału własnego w dużej części musi odzwierciedlać wynagrodzenie za ryzyko fundamentalne, a je możemy jedynie ocenić z perspektywy teraźniejszości (bieżących oczekiwań).

Przykład dla KGHM.

Akcje KGHM cieszą się dużą popularnością, ale jednocześnie są trudne do wyceny. Różnice w wycenach tej spółki różnych instytucji są olbrzymie. Fakt - ogromna zmienność cen miedzi powoduje, że wartość KGHM może bardzo szybko spaść i bardzo szybko wzrosnąć. Jednak paradoksalnie jest to właśnie dość pozytywny aspekt wyceny, ponieważ racjonalne oczekiwania będą polegały na uśrednianiu możliwych wydarzeń, a większe ryzyko będzie uwidocznione w większej oczekiwanej stopie zwrotu.

Wyznaczmy roczną wymaganą stopę zwrotu KGHM za pomocą CAPM. Dane obejmują okres od końca 1997 do końca 2011. Pobieramy dane ze stooq.pl. Wymagana stopa zwrotu obejmuje nie tylko wzrost kapitałowy ale także z dywidend. Stooq.pl zawiera opcję uwzględniania dywidend w kursie. Na podstawie wpisu

Dlaczego indeks ważony kapitalizacją uważany jest za benchmark? wiadomo już, że indeks giełdowy stanowi przybliżenie portfela rynkowego. Przyjmiemy oczywiście za portfel rynkowy WIG. WIG jest to indeks uwzględniający także dywidendy.

Stopy zwrotu wraz ze średnimi przedstawia poniższa tabela:

Możemy graficznie porównać KGHM z WIG:

KGHM w tym okresie wzrósł wielokrotnie silniej od WIG. Roczna średnia arytmetyczna stopa zwrotu wyniosła prawie aż 49%, podczas gdy indeks 11,5%. Powstaje pytanie czy średnia stopa zwrotu KGHM nie była za duża? KGHM posiada dużą oczekiwaną stopę zwrotu, ponieważ jego wartość silnie zależy od czynników zewnętrznych: cen miedzi (które zależą od sytuacji makroekonomicznej) oraz czynników politycznych. Aby oszacować właściwą wymaganą stopę zwrotu, użyjemy wzoru SML.

Zanim jednak zastosujemy ten wzór, powinniśmy sprawdzić czy stopa zwrotu KGHM nie posiada przypadkiem rozkładu Levy'ego z nieskończoną wariancją. Ja używam programu J. P. Nolana Stable. Oczywiście obserwacji jest tu zdecydowanie za mało, by móc coś konkretnego powiedzieć. Jednak zamiast częstości rocznych, możemy użyć do sprawdzianu częstości kwartalnych. Program wylicza, że dla tych danych parametr alfa = 2, czyli KGH ma skończoną wariancję. Możemy zatem spokojnie zastosować klasyczny SML.

Pewien problem leży w wyznaczeniu stopy wolnej od ryzyka Rf. Za Rf najczęściej przyjmuje się średnią rentowność 52-tygodniowych bonów skarbowych. Jednak średnia rentowność bonów w danym okresie, których dane uzyskałem z portalu money.pl wynosi 8,59%, co jest spowodowane występowaniem bardzo dużej inflacji w początkowych latach badanego okresu.

Wydaje się, że aby prawidłowo wyznaczyć r, trzeba używać tych samych okresów co KGH zarówno dla WIG jak i Rf. Wymagana stopa zwrotu w różnych okresach może mieć bowiem inne parametry. Problem jednakże polega na tym, że przecież na podstawie danych historycznych chcemy wyliczyć oczekiwaną stopę zwrotu w teraźniejszości i przyszłości, a więc aproksymujemy przeszłość na teraźniejszość i przyszłość. Ale z tego wynika, że przyjmujemy te same parametry co w przeszłości. Nie można zgodzić się na to, aby Rf wyniosła 8,59%, ponieważ dziś rentowność bonów sk. wynosi 4,58%. W momencie gdy inflacja zaczęła silnie spadać, rentowność zaczęła się normować. I tak od 2003 r. do końca 2011 średnia rentowność bonów wynosi 5,2%. Przyjmiemy zatem za Rf = 5,2%, ponieważ taką wolną od ryzyka stopę można założyć w przyszłości.

Ostatnia kwestia to beta, do obliczenia której używamy wzoru:

Średnia stopa zwrotu WIG w danym okresie wynosi 11,48%. Na marginesie dodam, że o ile stopą wolną od ryzyka można manipulować, to już samą średnią stopą WIG nie można. Beta liczona jest bowiem w oparciu o stopy w danym w okresie, dlatego też Rm musi być dokładnie średnią arytmetyczną z tego okresu. Nie może być geometryczną średnią, ani jakąś inną którą sobie arbitralnie ustalamy. To jest zabronione, bo beta uwzględnia prawdziwą średnią arytmetyczną. Zatem jeśli np. w danym okresie Rm = 14%, to wstawiamy 14%, a nie 10% bo nam się tak wydaje lepiej.

Po obliczeniu bety, która wyszła 2,4 podstawiamy dane do wzoru na CAPM:

r = 5,2 + 2,4*(11,48-5,2) = 20,3%.

Otrzymana wymagana stopa zwrotu dla KGH wynosi 20,3%.

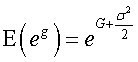

Porównując średnią stopę zwrotu KGH 49% z wymaganą stopą zwrotu 20,3% możemy początkowo wnioskować, że oczekiwana stopa zwrotu dla KGHM leży powyżej SML, czyli rynek jest czy był nieefektywny - KGH był za nisko wyceniony. W rzeczywistości ten wniosek może się okazać tylko pozorny. Arytmetyczna średnia będzie prawidłowa dla długich okresów obserwacji, lecz dla krótszych przypisze zbyt dużą wagę obserwacjom odstającym. Aby rozwiązać ten problem można użyć średniej geometrycznej za pomocą wzoru:

średnia geometryczna stopa zwrotu = (wartość końcowa/wartość początkowa)^[1/(n-1)] - 1.

Podstawiając dane dostaniemy (110,6/6,9229)^(1/(15-1)) - 1 = 21,9%.

Jak widać średnia geometryczna bardzo bliska jest wartości otrzymanej za pomocą CAPM. Jednakże średnia geometryczna ma jedną podstawową wadę: w ogóle nie uwzględnia wartości środkowych. Dlatego najlepszą estymację średniej uzyskuje się stosując regresję liniową wg następującego wzoru:

ln(kurs) = a + b*t + e

Współczynnik kierunkowy (b) tej funkcji staje się średnim procentowym wzrostem zmiennej objaśnianej. Podstawiając dane dla KGHM, otrzymałem b = 22,4%.

A zatem w tym przypadku średnia stopa zwrotu jest bardzo zbliżona do geometrycznej i nieco mniej do CAPM. Niemniej odchylenie jest niewielkie i widać, że CAPM prawidłowo wyliczył wymaganą stopę zwrotu. KGHM leży praktycznie na SML (rynek prawidłowo wycenia akcje).

Powstaje jednak pytanie czy statystyczna wycena (czy statyczna jak kto woli) będzie odpowiadać fundamentalnej. na razie wiemy tylko, że KGHM statystycznie jest dobrze wyceniony, co nie znaczy, że jest dobrze wyceniony na chwilę obecną - pełną dynamikę wyceny może jedynie oddać model dyskontowy uwzględniając fundamenty. Aby sprawdzić czy dzisiejsza rynkowa wycena KGHM jest prawidłowa, użyjemy wzoru Gordona, gdyż KGHM jest spółka, która konsekwentnie wypłaca dywidendy od 2005 r. Tak więc dane będą dotyczyć okresu 2005-2011.

Aby wyznaczyć wartość wewnętrzną akcji KGHM potrzebujemy wyliczyć tylko dwie zmienne: g oraz D(1), ponieważ r już obliczyliśmy. Zajmijmy się g. We wpisie

Analiza tempa wzrostu zysku firmy pisałem o 3 metodach szacowania stopy wzrostu zysku: historycznej, eksperckiej i fundamentalnej (teoretycznej). Najlepiej użyć wszystkich 3 i połączyć. Tak też zrobimy. Z historycznego punktu widzenia tempo g wyznaczamy w oparciu o parametr b' tendencji rozwojowej:

ln(dywidenda) = a' + b'*t

Ocena parametru b' wynosi 21,1%, choć przy dużym odchyleniu standardowym. Wartość ta jest większa niż r, więc nie może być użyta do wyceny: w którymś miejscu popełniamy błąd. Od razu warto sprawdzić czy przypadkiem nie mamy tu do czynienia z trendem nieliniowym. Logarytmiczna dywidenda ma następujący wykres:

Danych jest zbyt mało, by rozsądzać o trendzie. Powinniśmy więc zastąpić dywidendy zyskami. Sprawdźmy jak zyski rosną od 1998 do 2010 r. (pomijamy 2011, bo dywidendy odnoszą się do zysku z poprzedniego roku). Wyznaczenie tendencji rozwojowej musi tu odbyć się bez stosowania logarytmów, gdyż zyski w niektórych latach były ujemne. W takiej sytuacji często rozwiązuje się ten problem następująco:

1. najpierw wyznacza się regresję liniową dla samej zmiennej, czyli zysku, aby uzyskać średnią zmianę zysku równą współczynnikowi kierunkowemu regresji,

2. następnie oblicza się średni zysk w danym okresie

3. Dzieli się współczynnik kierunkowy z (1) przez średni zysk z (2), aby uzyskać średnią procentową zmianę zysku.

Okazuje się, że zysk średnio rośnie w tempie 24%, czyli zdecydowanie nadal zbyt dużo.

Widać więc, że metoda historyczna w tym przypadku jest niewystarczająca. Gdybyśmy dodatkowo posiadali pewne fundamentalne informacje, być może problem udałoby się rozwikłać. Podpowiedź znajdujemy w zdarzeniach ostatnich miesięcy.

W 2011 r. akcjonariusze KGHM mieli wyjątkowego pecha. Z jednej strony wyniki spółki były rekordowe, ale stało się tak w dużej części dzięki zdarzeniom jednorazowym. Z drugiej strony pojawiły się silne sygnały recesyjne w Europie i USA, co natychmiast przełożyło się na spadki notowań miedzi, a więc także KGHM. Pod koniec roku, gdy wydawało się, że kurs akcji może wrócić do ostatnich maksimów, jak obuchem uderzyła w rynek wiadomość o wprowadzeniu przez rząd podatku od niektórych kopalin, w tym miedzi. Kurs KGHM natychmiast zareagował potężną wyprzedażą.

Te negatywne zdarzenia wpłynęły na całą strukturę wyceny akcji. Łatwo to dostrzeżemy, gdy obliczymy r z CAPM ucinając rok 2011. Wtedy okazuje się, że r = 26,2%. Płyną z tego ważne wnioski. Stopa r prawdopodobnie zmniejszyła się z ok. 26 do ok. 20%. Również g spadło. Pytanie jak bardzo? Aby uzyskać odpowiedzieć na to pytanie, musimy się dowiedzieć, jaki wpływ ma nowy podatek na wyniki spółki. W artykule na forbes.pl

Podatek od kopalin zmniejszy potencjał KGHM czytamy:

Zdaniem analityka wprowadzenie podatku od kopalin da budżetowi Polski, przy obecnym poziomie cen miedzi, prawie 2,5 mld zł rocznie dodatkowych wpływów. To oznacza jednak, że KGHM będzie miał właśnie o taką kwotę mniej pieniędzy na inwestycje, dywidendę, czy inne projekty, na które chciałby wydać te pieniądze.

Połączmy ten fragment z prognozą zysku KGHM na 2012 r. W artykule money.pl

Najnowsza prognoza zysku netto dla KGHM czytamy, że spółka zakłada zysk na poziomie 3,8 mld zł. Dodając do 3,8 wartość 2,5 dostajemy 6,3 mld. Zatem stosunek 3,8/6,3 = 0,6 jest to wielkość korygująca zysk o podatek od kopalin. Oznacza to, że aby oszacować g po uwzględnieniu podatku, musimy przemnożyć stare g przez 0,6. Z regresji otrzymaliśmy 21,1%. Oznacza to, że właściwe g = 0,6*21,1% = 12,66%.

Porównamy następnie ten wynik z metodą fundamentalną. Metoda ta polega na zastosowaniu dla ROE = const, wzoru g = k*ROE, gdzie k = 1-dywidenda/zysk netto. Natomiast w ogólnym przypadku g(t) = k(t)*ROE(t) + s(t), gdzie s(t) = ROE(t)/ROE(t-1)-1. Oczywiście ROE zmienia się dla każdego okresu, ale nas interesują średnie wielkości - jeśli średnie ROE istnieje dla danego okresu, to różnice w ROE w różnych latach można potraktować jak odchylenia statystyczne. Dlatego też używamy pierwszego wzoru na g. Średni stosunek dywidenda/zysk netto w l. 2005-2011 wyniósł 0,485, czyli k = 1-0,485 = 0,515. Średnie ROE w okresie 2004-2010 wyniósł 38,7% (dywidenda liczona jest od zysku z zeszłego roku, czyli od 2004 do 2010). Czyli

g = 0,515*38,7% = 19,9%.

Otrzymany wynik metodą fundamentalną jest bardzo zbliżony do uzyskanego za pomocą regresji liniowej. Aby uzyskać właściwą wartość g, skorygujemy również tę wielkość o 0,6. Stąd g za pomocą metody fundamentalnej wynosi:

g = 0,6*19,9% = 11,94%.

Aby połączyć metodę ekonometryczną z fundamentalną, obliczmy średnią wyników z obu metod:

g = (12,66+11,94)/2 = 12,3%.

Liczba akcji KGH wynosi 0,2 mld. Ponieważ zysk KGHM w 2012 r. zakładany jest na poziomie 3,8 mld zł, to zysk na akcję wynosi 3,8 zł/0,2 = 19 zł. Wcześniej podałem, że średni stosunek dywidenda/zysk wynosi 0,485. Oczekiwana dywidenda z zysku za 2012 r. wypłacona w okresie 1 (w roku 2013) równa się:

0,485*19 zł = 9,215.

Obecnie jesteśmy po 1 kwartale 2012 r. + 1 miesiąc. Zatem oczekiwana dywidenda w okresie 1 dotyczy 2013 + 1 kwartał 2013 + 1 miesiąc 2013. Oczekiwana dywidenda wypłacona za rok, czyli na początku maja 2013 r. uwzględnia dodatkowe odpowiednio proporcjonalne tempo wzrostu w tym czasie, które wynosi 12,3%/4 + 12,3%/12 = 4,1%. (Ponieważ obliczamy wzrost za 1 kwartał + 1 miesiąc). Oczekiwana dywidenda wynosi:

D(1) = 9,215*(1+4,1%) = 9,6 zł.

Podstawmy dane do wzoru Gordona:

P(0) = D(1)/(r - g) = 9,6 /(0,203-0,123) = 120.

Nie można jednak zapomnieć, że dywidenda za 2011 r. jeszcze nie została wypłacona, ale jest już pewna i powiększa wirtualnie kapitał inwestora, a więc i wartość akcji. Gdy dywidenda zostanie wypłacona, kurs zmniejszy się o jej wysokość. W tym momencie wartość wewnętrzna nadal uwzględnia więc wartość jeszcze niewypłaconej dywidendy za 2011 r. Na podstawie artykułu

Dywidenda KGHM: możliwa wypłata 18 zł na akcję stwierdzamy, że jest to 18 zł. Tak więc całkowita wartość wewnętrzna akcji KGHM wynosi:

P(0) = 120 + 18 = 138 zł.

A teraz przyglądamy się kursowi akcji. Dziś kurs KGHM wynosi 137,7 zł.

Aby upamiętnić, że tyle rzeczywiście cena obecnie wynosi wklejam wykres:

Podsumowanie.

Przedstawiłem teoretyczną podstawę połączenia CAPM i wyceny akcji za pomocą modelu dyskontowego, a także uzasadniłem użycie prostego modelu Gordona. Przeprowadziłem badanie dla KGHM w dwóch kierunkach: użycia CAPM jako narzędzia estymacji oczekiwanej stopy zwrotu, którą następnie można zastosować do modelu Gordona. I tak po pierwsze prosty CAPM świetnie się sprawdził jako metoda wyznaczania oczekiwanej stopy zwrotu, ponieważ średnio tyle mniej więcej wynosi faktyczny zwrot z akcji. Po drugie model Gordona w połączeniu z CAPM również bardzo dobrze się sprawdził - widać, że rynek właśnie tej metody używa, ponieważ obecny kurs KGHM jest praktycznie równy teoretycznej wycenie. Prawdopodobnie stało się tak przez przypadek, ale zbieżność teorii do rzeczywistej ceny jest imponująca. Możemy stwierdzić, że rynek okazuje się fundamentalnie bardzo efektywny w przypadku akcji KGHM.

Źródło danych statystycznych:

stooq.pl

bankier.pl

money.pl