W

artykule na temat analizy dyskryminacyjnej wśród jej wad wymieniłem arbitralne ustalenie wielkości parametrów. Bo chociaż ustalamy je za pomocą regresji liniowej, to wyniki będą zależne od danych historycznych i przekrojowych. Dla rynku polskiego podałem model dyskryminacyjny Mączyńskiej-Zawadzkiego, który jednak został utworzony, a przez to też przeznaczony, dla firm produkcyjnych, usługowych i handlowych. Posłużyłem się nim do oceny Getinu, jednak ostatecznie stwierdziłem, że nie będzie prawidłowym modelem dla banków.

Model, który mógł posłużyć do analizy spółki o profilu finansowym, był za to model EM Altmana. Model ten został przystosowany do oceny zagrożenia firm na rynkach rozwijających się i jednocześnie także nieprodukcyjnych. Zastosowanie go dla Getinu wydawało się idealne, bo działa on właśnie w krajach rozwijających się (Polska, Rosja, Białoruś, Ukraina, Rumunia). Otrzymałem rating B-, co oznaczałoby, że bank znajduje się w górnym paśmie strefy zagrożenia (strefa ta znajduje się pomiędzy D a B).

Model EM Altmana jest dość trudny do zastosowania, gdy weźmiemy pod uwagę korekty, jakich należy dokonać już po uzyskaniu parametrów i ratingu. Ja w swoich obliczeniach dokonałem sporego uproszczenia dla przyspieszenia rachunków, co może prowadzić do zniekształceń prawidłowej oceny zagrożenia. Zaleta tego modelu, czyli ogólność, to także jego wada: firma może być produkcyjna i nieprodukcyjna, tj. usługowa, handlowa lub instytucja finansowa i ubezpieczeniowa.

Wśród polskich publikacji możemy znaleźć analizę dyskryminacyjną wykonaną, a więc i przeznaczoną, tylko dla banków. T. Siudek [1] przestudiował kondycję finansową 1551 banków spółdzielczych w Polsce w latach 1995-2002. Uzyskał następujący model:

Z = 0,0399 X1 - 0,11592 X2 - 0,206739 X3 + 0,022422 X4 - 0,332494

gdzie:

X1 - Wskaźnik rentowności kapitałów własnych, ROE

X2 - Wskaźnik udziału majątku i inwestycji kapitałowych w aktywach netto

X3 - Wskaźnik udziału kapitału pracującego w aktywach netto

X4 - Wskaźnik udziału kredytów netto w aktywach netto

Wartością progową jest 0. Wartość powyżej 0 oznacza niewypłacalność banku, a poniżej 0 - wypłacalność. Autor uznał bank za niewypłacalny, jeśli wskaźnik wypłacalności był niższy od 8%. Poziom ten został dobrany właściwie, bo właśnie 8% to minimalny poziom, jakiego wymaga polskie prawo bankowe. Czyli - to trzeba podkreślić -

ta analiza nie ma na celu przewidywać bankructwa, tylko zagrożenie, że wskaźnik wypłacalności będzie zbyt niski. Jest to oczywiście pośrednie badanie prawdopodobieństwa bankructwa, ale nie jest ono tożsame z szacowaniem zagrożenia bankructwem.

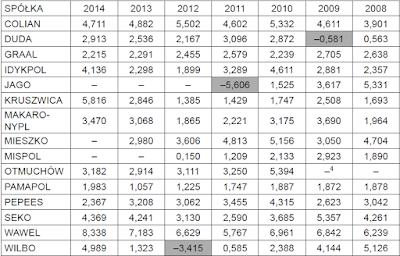

Trafność klasyfikacji banków do grupy wypłacalnych i niewypłacalnych za pomocą funkcji dyskryminacji przedstawia tabela:

Źródło: Siudek, T. [2005]

Aby ocenić trafność funkcji dyskryminacyjnej Siudka możemy zacząć od pytania czy model prognozuje zagrożenie czy nie, a następnie porównać ten wynik z rzeczywistością (tj. czy rzeczywiście wskaźnik wypłacalności spadł poniżej 8%). I tak:

* model prognozował poprawnie zagrożenie na 78,17% (czyli niepoprawnie na 21,83%)

* model prognozował poprawnie brak zagrożenia na 91,49% (czyli niepoprawnie na 8,51%).

Oznacza to, że model miał wysoką trafność i możemy spróbować go zastosować do oceny wypłacalności banków.

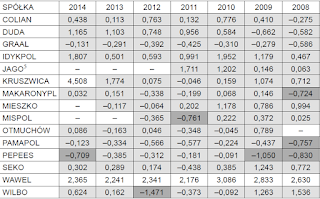

Dodatkowo możemy zobaczyć jak kształtowały się średnie wielkości zmiennych na wykonanej próbie banków wypłacalnych i niewypłacalnych:

Źródło: Siudek, T. [2005]

Zauważmy, że zmienna X2 jest bardzo zbliżona w obu grupach - zmienna ta okazała się nieistotna statystycznie.

Średnia wartość funkcji Z banków wypłacalnych wyniosła -0,28, a niewypłacalnych 2,08.

Przykład:

Grupa Kapitałowa Getin Holding S.A.

Powtórzmy test dla GTN - także na 31.03.2018, dla danych rocznych (zaanualizowanych).

X1 = ROE = 282 955 / 3 199 924 = 8,84%.

Druga zmienna X2 nie została niestety jasno zdefiniowana. Majątek to przecież aktywa, a inwestycje kapitałowe należą do aktywów. Na szczęście jak pamiętamy zmienna ta jest nieistotna. Dlatego przyjmę po prostu średnią wielkość 5,21%, co nie wpłynie na ocenę banku:

X2 = 5,21%

X3 = kapitał pracujący / kapitał własny = (Aktywa Obrotowe – Zobowiązania Bieżące)/kapitał własny = (25 288 888 - 23 492 963)/3 199 924 = 56,1%

Zmienna X4 także nie została dobrze zdefiniowana, ponieważ nie wiem co znaczą "kredyty netto". Możemy się spotkać z określeniem dług netto. Są to zobowiązania oprocentowane - (środki pieniężne + ekwiwalenty).

Za zobowiązania oprocentowane powinienem przyjąć kredyty, pożyczki, obligacje, leasing. Rozciągam więc tu definicję kredytów do obligacji i leasingu, bo nie ma powodu, by traktować te instrumenty oddzielnie.

X4 = (Zobowiązania wobec innych banków i instytucji finansowych + Zobowiązania z tytułu emisji dłużnych papierów wartościowych - Kasa, środki w Banku Centralnym - Należności od banków i instytucji finansowych) / kapitał własny = (1 445 112 - 635 874 - 348 312) / 3 199 924 = 14,4%.

Podstawiamy:

Z = 0,0399*8,84% - 0,11592*5,21% - 0,206739*56,1% + 0,022422*14,4% - 0,332494 = -0,45.

Ujemny wynik wskazywałby, że GTN nie ma żadnych problemów z wypłacalnością, nie jest zagrożony.

Zrobię teraz pewne korekty. Zwróćmy uwagę, że zobowiązania oprocentowane to także zobowiązania wobec klientów. Gdybyśmy je dodali, wtedy ostatnia zmienna drastycznie się zmieni:

X4 = (Zobowiązania wobec innych banków i instytucji finansowych + Zobowiązania wobec klientów + Zobowiązania z tytułu emisji dłużnych papierów wartościowych - Kasa, środki w Banku Centralnym - Należności od banków i instytucji finansowych) / kapitał własny = (1 445 112 + 20 268 951 - 635 874 - 348 312) / 3 199 924 = 647,8%.

Z = 0,0399*8,84% - 0,11592*5,21% - 0,206739*56,1% + 0,022422*647,8% - 0,332494 = -0,31.

Zatem nadal GTN pozostaje niezagrożony i co więcej trzyma się średniego poziomu Z dla grupy banków wypłacalnych.

Drugą korektą, jaką warto przeprowadzić, jest zamiana zysku netto na dochód całkowity. Banki spółdzielcze są bankami lokalnymi, które, jak sądzę, nie rozdzielają zysków od dochodów. W przypadku dużych firm prowadzących rachunkowość zgodnie z MSR to rozdzielenie staje się konieczne. O różnicach między zyskami a dochodami nie piszę, bo w internecie jest masa o tym informacji. Zasygnalizuję tylko, że w tym przypadku kapitał własny spółki nie jest wcale zwiększany o zysk netto, ale właśnie o dochód całkowity, co dowodzi, że to właśnie ten drugi jest najbardziej istotny. Dlaczego więc zysk netto nadal pozostaje ważny w analizie i jest podkreślany? Wadą dochodu całkowitego jest jego zmienność w czasie, przez co spoglądanie tylko przez jego pryzmat bywa krótkowzroczne. Zysk netto pozostaje bardziej stabilny w kolejnych latach, przez co łatwiej prognozowalny (zob. [2]). Z drugiej strony dochód całkowity szybciej poinformuje nas, gdy spółka wpadnie w kłopoty finansowe. Dlatego to krótkoterminowe spojrzenie będzie tutaj miało większe znaczenie.

Stąd pierwsza zmienna przyjmie wartość:

X1 = ROE = 208 490 / 3 199 924 = 6,5%.

Dostaniemy:

Z = 0,0399*6,5% - 0,11592*5,21% - 0,206739*56,1% + 0,022422*647,8% - 0,332494 = -0,31.

Poziom Z się nie zmienił, czyli GTN pozostaje ciągle bezpieczny.

Głębsze spojrzenie na niektóre pozycje aktywów może znów zmienić rezultat. W aktywach bieżących umieściłem bowiem należności od klientów. Trudno jednak zakładać, że wszystkie te należności są krótkookresowe: jest to wielka kwota ponad 17 mld zł. Getin w swoim sprawozdaniu niestety nie rozdziela aktywów na krótko- i długoterminowe, ale są one ułożone od najbardziej płynnych do coraz mniej płynnych. Na pewnej pozycji pojawiają się wartości niematerialne i prawne, które należy uznać za początek listy aktywów trwałych. Należności od klientów znajdują na wyższej pozycji, co sugeruje ich krótkoterminowość. Brak formalnego podziału na aktywa trwałe i obrotowe wymusza od nas pewnych uproszczeń. Dlatego pozycję należności od klientów podzielę na 2, aby uzyskać bardziej obiektywną miarę bieżących należności. Aby zachować sprawiedliwy podział, to jednocześnie podzielę na dwa zobowiązania wobec klientów. Wtedy:

X3 = kapitał pracujący / kapitał własny = (Aktywa Obrotowe – Zobowiązania Bieżące)/kapitał własny = (16 591 838,5 - 13 358 487,5) / 3 199 924 = 101%.

Otrzymamy:

Z = 0,0399*8,84% - 0,11592*5,21% - 0,206739*101% + 0,022422*647,8% - 0,332494 = -0,41.

Z tego punktu widzenia wypłacalność GTN nawet się poprawiła.

Jeśli spojrzymy na tę analizę krytycznie, to zauważymy, że posiada jedną niedoskonałość. Banki spółdzielcze w badaniu Siudka to były faktycznie banki, natomiast Getin Holding to zdecydowanie więcej niż bank: to cała instytucja finansowa, której działalność obejmują usługi bankowe, leasingowe, windykacyjne i inne finansowe. Dlatego przeprowadzę jeszcze ten sam test dla Idea Bank, który stanowi ważny element GTN.

Idea Bank SA.

Kurs akcji także potężnie spadł i znajduje na skrajnie niskich poziomach (C/WK = 0,12 !!!), co może wywołać przeświadczenie, że spółkę czeka bankructwo. Wartości w tys zł. Podobnie jak dla GTN dane pochodzą z bilansu na 31.03.2018, a rachunek wyników zaanualizowałem ze sprawozdań (1kw 2018 - 1kw 2017 + cały rok 2017). Tym razem jednak od razu ujmę dochody całkowite, a nie zysk netto.

Całkowite dochody = 14 193 - 64 343 + 281 261 = 231 111

Kapitał własny = 2 437 170

X1 = ROE = 231 111 / 2 437 170 = 9,5%

Zmienna X2 była, jak już wiemy, nieistotna statystycznie, więc przyjmuję na poziomie średniej:

X2 = 5,21%

Aktywa Obrotowe = 21 490 287

Zobowiązania Bieżące = 20 674 598

X3 = kapitał pracujący / kapitał własny = (Aktywa Obrotowe – Zobowiązania Bieżące)/kapitał własny = (21490287 - 20674598) / 2437170 = 33,5%

X4 = (Zobowiązania wobec innych banków i instytucji finansowych +

Zobowiązania wobec klientów + Zobowiązania z tytułu emisji dłużnych

papierów wartościowych - Kasa, środki w Banku Centralnym - Należności od

banków i instytucji finansowych) / kapitał własny = (907 406 + 17 986 283 + 521 679 - 221 818 - 151 362) / 2 437 170 = 781,3%.

Podstawiamy:

Z = 0,0399*9,5% - 0,11592*5,21% - 0,206739*33,5% + 0,022422*781,3% - 0,332494 = -0,23.

Powyższa analiza wskazywałaby, że Idea Bank nie ma problemów z wypłacalnością.

Zróbmy jeszcze dla Idei tę samą ostatnią korektę co dla GTN, czyli uwzględnimy tylko połowę należności wobec klientów oraz połowę zobowiązań wobec klientów. Wtedy trzecia zmienna równa się:

X3 = kapitał pracujący / kapitał własny = (Aktywa Obrotowe – Zobowiązania Bieżące)/kapitał własny = (13 297 127 - 11 681 456,5) / 2437170 = 66,3%

Podstawiamy:

Z = 0,0399*9,5% - 0,11592*5,21% - 0,206739*66,3% + 0,022422*781,3% - 0,332494 = -0,3.

W sumie wskaźnik poprawił się tak samo jak dla holdingu.

Dla porównania tych wyników z rynkiem, sprawdziłem dodatkowo GNB,

mBank, PKO BP oraz ING BŚ. Ten sam zakres na 1 kw. 2018 na danych

zannualizowanych.

Getin Noble Bank:

X1a = Wynik netto / kapitał własny = -14,4%.

X1b = Dochód całkowity / kapitał własny = -12,3%.

X2 - analogicznie jak w poprzednich przykładach, bierzemy średnią dla wypłacalnych i niewypłacalnych:

X2 = 5,21%

X3 = (Aktywa Obrotowe – Zobowiązania Bieżące)/kapitał własny = 43,86%

X4 = (Zobowiązania wobec innych banków i instytucji finansowych +

Zobowiązania wobec klientów + Zobowiązania z tytułu emisji dłużnych

papierów wartościowych - Kasa, środki w Banku Centralnym - Należności od

banków i instytucji finansowych) / Kapitał własny =1400%.

Z(a) = 0,0399 *X1a - 0,11592 *X2 - 0,206739 *X3 + 0,022422*X4 - 0,332494 = -0,121.

Z(b) = 0,0399 *X1b - 0,11592 *X2 - 0,206739 *X3 + 0,022422*X4 - 0,332494 = -0,12.

Analiza

ta wskazuje, że GNB jest niebezpiecznie blisko 0, co rodzi pewne ryzyko

niewypłacalności. Możemy pospekulować, że zejście Z do zera, będzie

oznaczać rating CCC, a potem z każdym kolejnym wzrostem coraz bliżej D.

Dopóki GNB nie zejdzie do samego zera, twierdzenie, że Getin Noble to bankrut, jest przesadą i

na obecną chwilę bank nie ma problemów z pokryciem zobowiązań.

Mbank:

X1a = ROE = zysk netto / kapitał własny = 1287070 / 14484158 = 8,9%

X2 - analogicznie jak w poprzednich przykładach, bierzemy średnią dla wypłacalnych i niewypłacalnych:

X2 = 5,21%

X3 = (Aktywa Obrotowe – Zobowiązania Bieżące)/kapitał własny = (130813879 - 116289638) / 14484158 = 100,3%

X4

= (Zobowiązania wobec innych banków i instytucji finansowych +

Zobowiązania wobec klientów + Zobowiązania z tytułu emisji dłużnych

papierów wartościowych - Kasa, środki w Banku Centralnym - Należności od

banków i instytucji finansowych) / Kapitał własny = (115355334-5354319)

/ 14484158 = 759,5%.

Z(a) = 0,0399 *X1a - 0,11592 *X2 - 0,206739 *X3 + 0,022422*X4 - 0,332494 = -0,372

Analogicznie sprawdzimy ten model dla

X1b = Dochód całkowity / kapitał własny = 1460332 / 14484158 =10%.

Z(b) = 0,0399 *X1b - 0,11592 *X2 - 0,206739 *X3 + 0,022422*X4 - 0,332494 = -0,371.

Tak więc mbank ma porównywalny Z-score do GTN, co sugeruje, że charakteryzuje się podobnym stopniem wypłacalności.

PKO BP:

X1a = zysk netto / kapitał własny = 8,2%

X1b = dochód całkowity / kapitał własny = 9,7%.

X2 = 5,21%

X3 = 163,8%

X4 = 620,4%.

Z(a) = 0,0399 *X1a - 0,11592 *X2 - 0,206739 *X3 + 0,022422*X4 - 0,332494 = -0,535

Z(b) = 0,0399 *X1b - 0,11592 *X2 - 0,206739 *X3 + 0,022422*X4 - 0,332494 = -0,534

Widać, że PKO mocno trzyma w ryzach wskaźniki płynności i daleko mu do zagrożenia. Prawdopodobnie wynika to z bardziej konserwatywnej strategii rozwoju tego banku.

ING Bank Śląsk:

Dochód całkowity jest zbliżony do zysku netto i Z-score jest niemal identyczny w obu wariantach, stąd podaję tylko wersję Z(b):

X1 = 12,6%

X2 = 5,21%

X3 = 106,1%

X4 = 897,6%

Z = -0,352.

W

przypadku ING należy zwrócić na jeden aspekt. Wysoki poziom ROE 12,6%

(w wersji X1a 11,8%) przyczynia się do wysokiego poziomu C/WK, który

obecnie wynosi niemal dwukrotność kapitału własnego. Natomiast z punktu widzenia

wypłacalności, bank jest przeciętny. Poziom -0,35 jest podobny zarówno

do GTN jak i MBK.

Biorąc pod uwagę, że MBK i PKO mają rentowności podobne do

GTN, a MBK i ING mają także Z-score podobny do GTN, trudno racjonalnie

wytłumaczyć tak głębokie, niekończące się spadki Getin Holdingu, nawet

biorąc pod uwagę słabsze wskaźniki Idei i powiązanego z nimi Getin

Noble.

Podsumowując, dokładniejsza analiza dyskryminacji wydaje się odrzucać ryzyko niewypłacalności Getinu. Na pewno jest to optymistyczna wiadomość dla posiadaczy akcji GTN i Idea Bank. Pamiętać trzeba jednak, że nie jest to pełna analiza zagrożenia upadłością. Nie jest też to jedyna metoda służąca do oceny tego zagrożenia.

Literatura:

[1] Siudek, T., Prognozowanie Upadłoś

ci Banków

Spółdzielczych w Polsce przy Użyciu Analizy Dyskryminacyjnej, 2005;

[2] Sajnóg, A., Analiza komparatywna wartości dochodu całkowitego i zysku netto w perspektywie corporate governance, 2014.