To twierdzenie będzie jednak tylko wtedy prawdziwe, gdy oczekiwane zyski będą skorelowane z oczekiwanymi zyskami całego rynku, szerzej z gospodarką. Aby zrozumieć dlaczego, trzeba wrócić do artykułu Rozbieżność opinii w kontekście CAPM , gdzie został przedstawiony następujący wzór na cenę ryzyka uwzględniającą rozbieżność opinii:

gdzie lewa część równania przedstawia wzór znany z CAPM,

- ryzyko inwestycji jest subiektywne dla każdego k-tego inwestora;

- awersja do ryzyka jest subiektywnym elementem każdego k-tego inwestora;

- cena ryzyka powstaje przez pomnożenie uśrednionej dla wszystkich inwestorów awersji do ryzyka i uśrednioneego dla wszystkich inwestorów ryzyka mierzonego kowariancją cen.

Jeżeli kowariancja pomiędzy cenami akcji będzie równa 0 (poprzez brak korelacji), wtedy nawet bardzo duża awersja do ryzyka nie zwiększy stopy zwrotu, gdyż awersja jest przemnożona przez kowariancję. Kiedy tak się dzieje? Oczywiście wtedy, gdy mamy do czynienia z zyskami monopolistycznymi, wynikającymi z przewagi rynkowej, wykorzystywania patentów, know-how.

Zmienność takich zysków będzie podwyższać wartość wewnętrzną akcji, a nie obniżać. W artykule Kiedy większa niepewność zwiększa wartość akcji? wyprowadziłem następujący wzór na wskaźnik wartość wewnętrzna akcji / wartość księgowa:

gdzie:

P(0) - wartość wewnętrzna akcji

BV(0) - wartość księgowa firmy

G - wartość oczekiwana logarytmicznej stopy wzrostu zysku firmy

σ^2 - wariancja logarytmicznej stopy wzrostu zysku firmy

r - logarytmiczna wymagana stopa zwrotu

T - czas po którym wartość wewnętrzna akcji staje się wartością księgową firmy.

Powyższy wzór zakłada, że stopa wzrostu zysku firmy ma rozkład normalny. Nawet jeśli jest to nieprawda, to przy braku wartości odstających możemy ją tym rozkładem przybliżyć.

Wzór ten dowodzi, że przy niezmienionej wymaganej stopie zwrotu (czyli braku korelacji z rynkiem) wyższe oczekiwane zyski oraz wyższa zmienność oczekiwanej stopy wzrostu zysków, czyli ich wariancja, będzie podnosić wartość akcji.

Wiadomo, że gdy firma przygotowuje się na likwidację, to wartość wewnętrzna powinna się zrównać z wartością księgową - pamiętajmy, że mówimy o bieżącej wartości księgowej, a więc takiej, której składniki aktywów są wyceniane na dziś. Nie wiemy kiedy spółka zostanie zlikwidowana i nie mamy zamiaru wróżyć z fusów. Dlatego zmienna T pozostanie zmienna. Inaczej jest w przypadku pozostałych zmiennych, które możemy oszacować.

Jeśli stworzymy warunek:

G + σ^2/ 2 - r = 0

czyli:

r = G + σ^2/ 2

to niezależnie od T zawsze P / BV będzie równe 1. Oznacza to, że warunek "bezpiecznej wyceny" jest dany przez nierówność:

Jeśli średnia stopa zmian zysków + połowa wariancji będzie co najmniej równa wymaganej stopie zwrotu, wtedy wiemy, że P / BV powinno być co najmniej równe 1.

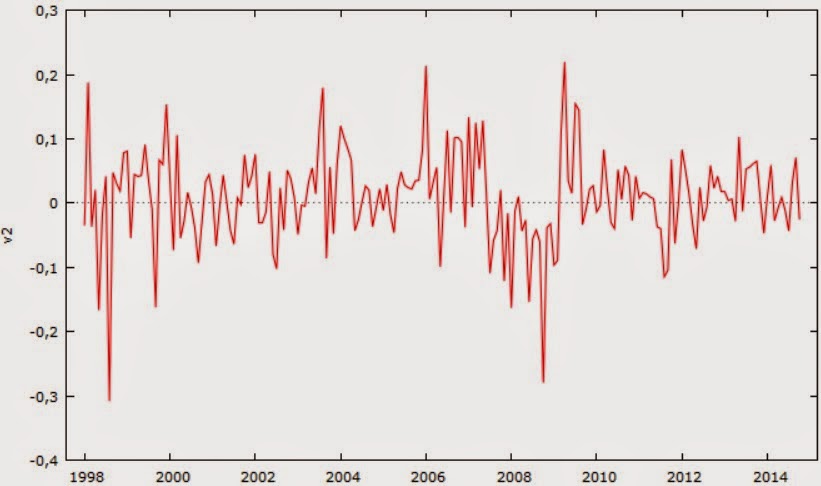

Załóżmy, że znajdujemy akcje, które spełniają ten warunek, tak że r jest znacznie mniejsze od prawej strony, a jednocześnie cena byłaby niższa od BV. Można byłoby przypuszczać, że akcje są niedowartościowane. Jednak najbezpieczniejsze podejście polega na tym, aby w to wątpić. A przypomnieć to sobie można choćby przez przypomnienie wzoru na cenę ryzyka z rozbieżnością opinii. Jeżeli stopa wzrostu zysku lub ich wariancja podnosi się, to trzeba mieć pewność, że ten wzrost nie jest efektem korelacji z rynkiem. Ale jak to można szybko ocenić? Wydaje się, że paradoksalnie bessa jest tu błogosławieństwem: jeżeli cały rynek znajduje się od dłuższego czasu w fazie niedźwiedzia, a zyski spółki rosną coraz bardziej, wtedy racjonalnie można założyć, że są one nieskorelowane.

Przykład: KGHM

Na dzień, w którym piszę ten artykuł akcje KGHM są wyceniane dokładnie na poziomie oficjalnego kapitału własnego.Wiadomo jednak, że 4 kwartał już minął i akcje muszą uwzględniać zysk z tego okresu. Ponieważ w KGHM nie występuje sezonowość, 4 kwartał można prognozować w oparciu o poprzednie kwartały. Prognozę tę wyznaczyłem jako średnią arytmetyczną 3 ostatnich kwartałów. Dane skonsolidowane pobrałem z portalu bankier.pl, są wyrażone w tys. zł.

Rzeczywisty kapitał własny wynosi więc BV*(1 + 0,024). Zatem akcje są wyceniane nieco poniżej BV. Ustalmy teraz średnią stopę wzrostu zysku i jej odchylenie. Historyczne zyski operacyjne i netto są przedstawione poniżej:

Zamieniłem te wartości na logarytmy, stworzyłem równanie trendu liniowego i uzyskałem następujący trend dla zysku operacyjnego:

Przykład: KGHM

Na dzień, w którym piszę ten artykuł akcje KGHM są wyceniane dokładnie na poziomie oficjalnego kapitału własnego.Wiadomo jednak, że 4 kwartał już minął i akcje muszą uwzględniać zysk z tego okresu. Ponieważ w KGHM nie występuje sezonowość, 4 kwartał można prognozować w oparciu o poprzednie kwartały. Prognozę tę wyznaczyłem jako średnią arytmetyczną 3 ostatnich kwartałów. Dane skonsolidowane pobrałem z portalu bankier.pl, są wyrażone w tys. zł.

Rzeczywisty kapitał własny wynosi więc BV*(1 + 0,024). Zatem akcje są wyceniane nieco poniżej BV. Ustalmy teraz średnią stopę wzrostu zysku i jej odchylenie. Historyczne zyski operacyjne i netto są przedstawione poniżej:

Zamieniłem te wartości na logarytmy, stworzyłem równanie trendu liniowego i uzyskałem następujący trend dla zysku operacyjnego:

Wykres dla zysków netto ma bardzo podobny kształt, więc nie będę go pokazywał.

Nachylenie powyższego trendu jest pewną średnią logarytmiczną stopą wzrostu zysku (Istota i znaczenie logarytmicznej stopy zwrotu). Dla zysku operacyjnego wychodzi 14,3%, dla zysku netto 16,3%. Nie można jednak nie brać pod uwagę informacji bieżących. Zarząd KGHM prognozuje wzrost EBITDA o 70% do 2020 r. w stosunku do 2014. Oznacza to tylko 9,2% rocznie (czyli logarytmicznie 8,8%). A przecież pamiętajmy, że 14,3% to stopa logarytmiczna, a więc zwykła to ponad 15%. Z pewnością dla wielu inwestorów jest to rozczarowanie. Stopa wzrostu EBIT może być jak najbardziej przybliżona przez EBITDA, natomiast zysk netto już gorzej. Jednak to właśnie zyski operacyjne najlepiej odzwierciedlają faktyczną sytuację finansową i przez to ich parametry stają się lepszymi prognostykami niż zysk netto.

Wariancja log stopy wzrostu zysku operacyjnego wyniosła w okresie 1998-2014 0,76. Tę wartość pozostawię bez zmian.

Ostatnia kwestia to koszt kapitału własnego. Zamiast obliczać od samego początku tę wartość, posłużę się już gotową analizą z artykułu: Jak CAPM wiąże się z teorią wyceny akcji? Przykład wyceny KGHM gdzie szacowałem r na poziomie ok. 0,2. Zamieniając ją na logarytmiczną stopę, dostajemy 0,182.

Jeśli podstawimy dane do wzoru:

G + σ^2/ 2 - r = 0,088 + 0,76/2 - 0,182 = 0,29

Warunek bezpiecznej wyceny zostaje spełniony. Teraz tylko pytanie czy akcje są dobrze wycenione? Wiemy, że jeśli dostaliśmy wartość dodatnią, to znaczy, że akcje powinny być nie mniejsze od wartości księgowej. W jakiej sytuacji będą równe wartości księgowej? Zauważmy, że:

P / BV = e^(0,29T) = 1,34*e^T

A więc wtedy i tylko wtedy, gdy T = 0, to P / BV = 1. Innymi słowy, inwestorzy uważają, że wartość akcji jest dziś równa wartości księgowej, ponieważ zawsze wedle tego wzoru po czasie T wartość akcji zrównuje się z wartością księgową.

Jednak wiemy, że wartość księgowa jest równa dziś oficjalnej BV razy (1+0,024) . Ponadto musimy uwzględnić fakt, że obecna wartość rynkowa akcji zawiera już dywidendę za 2014, podczas gdy wartość wewnętrzna nie zawiera jej. Na podstawie raportu http://www.bankier.pl/wiadomosc/KGHM-POLSKA-MIEDZ-SA-Polityka-Dywidend-7233376.html wnioskujemy, że dywidenda wyniesie 1/3 jednostkowego zysku netto, a więc ok. 4 zł. W sumie więc powinniśmy uzyskać warunek:

(P - 4) / BV(1+0,024) = 1

BV=121,25, więc 121,25*1,024 = 122,3 zł.

Obecna cena akcji P = 121 zł, więc 121-4 = 117 zł.

117 / 122,3 = 0,96 < 1.

Wynika z tego, że akcje mogą być dziś minimalnie niedowartościowane. Ich wartość rynkowa powinna wynieść co najmniej 122,3+4 = 126,3 zł, a więc 126,3/121 = 1,04.

Rynek jest wstrzemięźliwy, ale trzeba stwierdzić, że dziś wycenia akcje KGHM prawidłowo, ponieważ odchylenie 4% w jedną czy w drugą stronę jest nieistotne statystycznie. Osobiście uważam, że dopiero odchylenie powyżej 10% powinno skłonić do zastanowienia się czy jakichś czynników nie uwzględniliśmy, potem dopiero nad niedowartościowaniem.

Źródło:

www.bankier.pl